🤖 AI智能摘要

+该项目为MkDocs文档系统提供AI驱动的智能摘要生成和阅读统计功能,支持OpenAI、DeepSeek等多API服务。核心特性包括自动生成80-120字高质量摘要、多语言支持、智能内容清理和高效缓存系统,同时提供精准的中文阅读统计和阅读时间估算。通过灵活的配置选项,用户可实现文件夹或页面级别的精确控制,并自定义API服务和提示词。该工具显著提升了技术文档的可读性和管理效率。

+📖 阅读信息

+阅读时间:2 分钟 | 中文字符:912 | 有效代码行数:134

+MkDocs AI Hooks¶

+仓库地址:https://github.com/Wcowin/mkdocs-ai-hooks

+

+

🚀 您的MkDocs文档首选智能摘要!

+这个项目利用MkDocs hooks,为您的技术文档和博客添加AI驱动的摘要生成和智能阅读统计功能。

+ +

+

网站效果预览:https://wcowin.work/Mkdocs-Wcowin/blog/Mkdocs/mkfirst/

+✨ 功能特性¶

+AI智能摘要¶

+-

+

- 自动生成文章摘要:使用DeepSeek API生成高质量的80-120字摘要 +

- 多语言支持:支持中文、英文等多种语言 +

- 多API服务支持:支持OpenAI、Claude等多种AI服务 +

- 智能内容清理:自动过滤YAML、HTML、代码块等格式内容 +

- 备用摘要机制:API失败时提供基于规则的智能摘要 +

- 高效缓存系统:避免重复API调用,7天智能过期 +

- 灵活配置:支持文件夹级别和页面级别的精确控制 +

智能阅读统计(可选)¶

+-

+

- 精准中文字符统计:专门优化的中文内容识别 +

- 智能代码检测:识别多种编程语言和命令行代码 +

- 阅读时间估算:基于中文阅读习惯的400字/分钟计算 +

- 美观信息展示:使用MkDocs Material风格的信息框 +

智能化特性¶

+-

+

- 自动语言识别:支持30+编程语言和标记语言 +

- 内容类型检测:区分代码、配置、命令行等不同内容 +

- 缓存优化:LRU缓存提升性能 +

- 错误处理:完善的异常处理和日志记录 +

📦 安装¶

+方法1¶

+直接下载(推荐)

+在releases页面下载,解压后将以下文件放入您的MkDocs项目的docs/overrides/hooks中:

+https://github.com/Wcowin/mkdocs-ai-hooks/releases

或者下载上方hooks目录下的两个Python文件:

+-

+

-

+

+ai_summary.py:AI摘要生成器

+ -

+

+reading_time.py:阅读时间统计器

+

+

+在 mkdocs.yml 中theme下添加custom_dir:

+

方法2¶

+使用Git克隆 +

依赖安装¶

+🚀 快速开始¶

+1. 配置MkDocs¶

+先执行一次mkdocs build,生成缓存文件

+

mkdocs.yml 中添加hooks,theme下添加custom_dir:

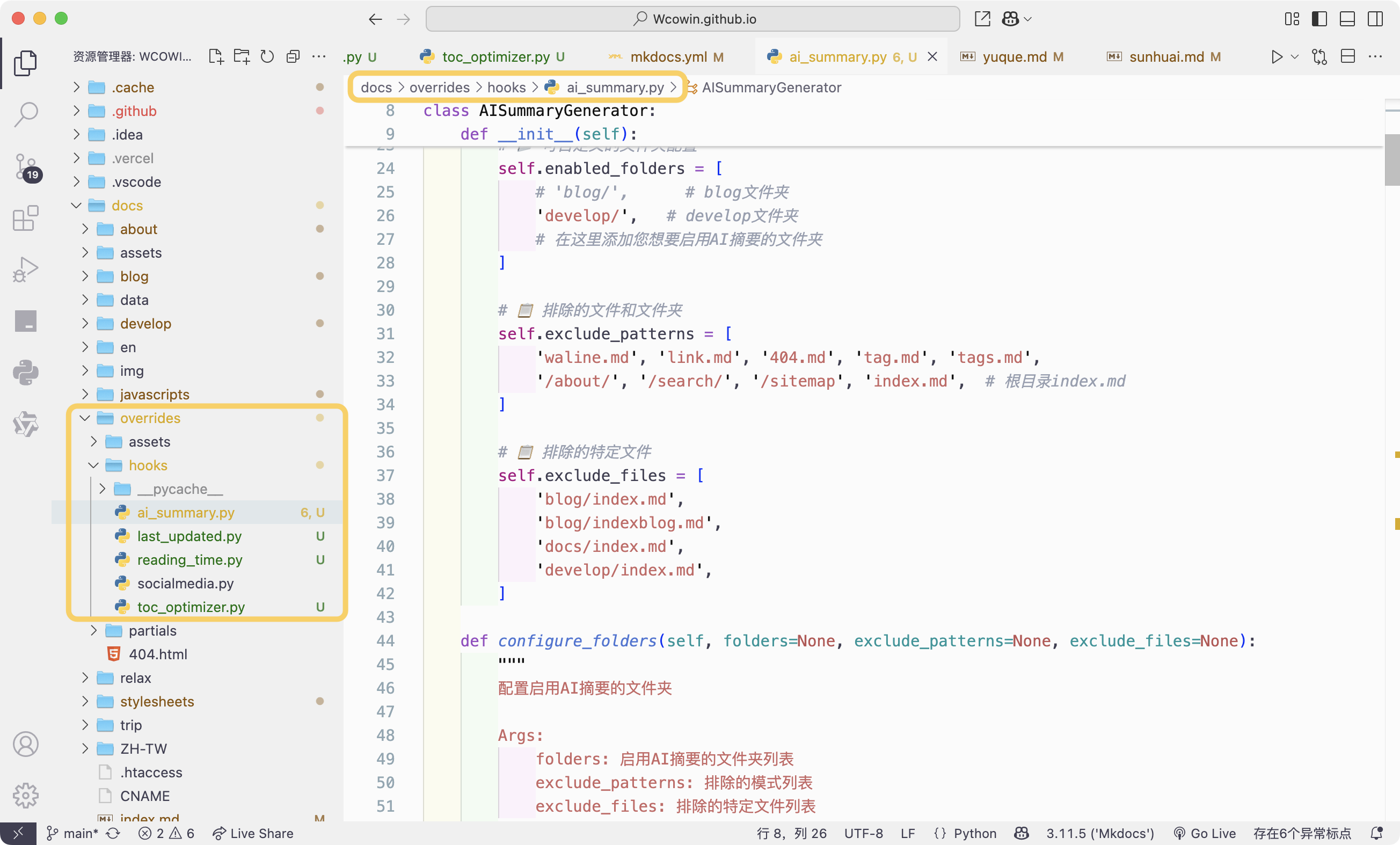

+2. 在ai_summary.py中配置需要AI摘要的目录¶

+3. 在ai_summary.py中设置DeepSeek API(默认是OpenAI)¶

+4. 运行MkDocs¶

+第一次运行时,可能需要等待一段时间,因为系统会自动生成摘要。后续运行时,系统会使用缓存数据,加快生成速度。 +

+终端输出如下: + +

+📖 使用指南¶

+AI摘要配置¶

+文件夹级别控制¶

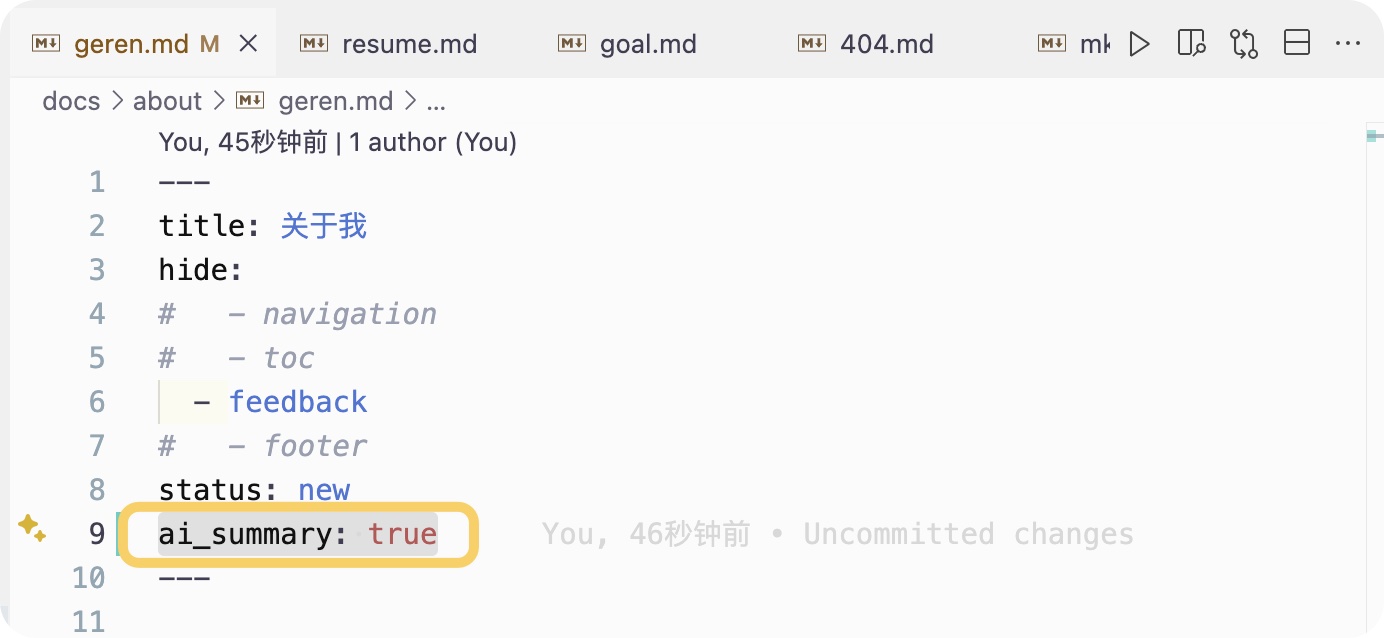

+页面级别控制(推荐)¶

+在Markdown文件的YAML front matter中:

+ + +

+

+

+阅读时间配置¶

+排除特定页面¶

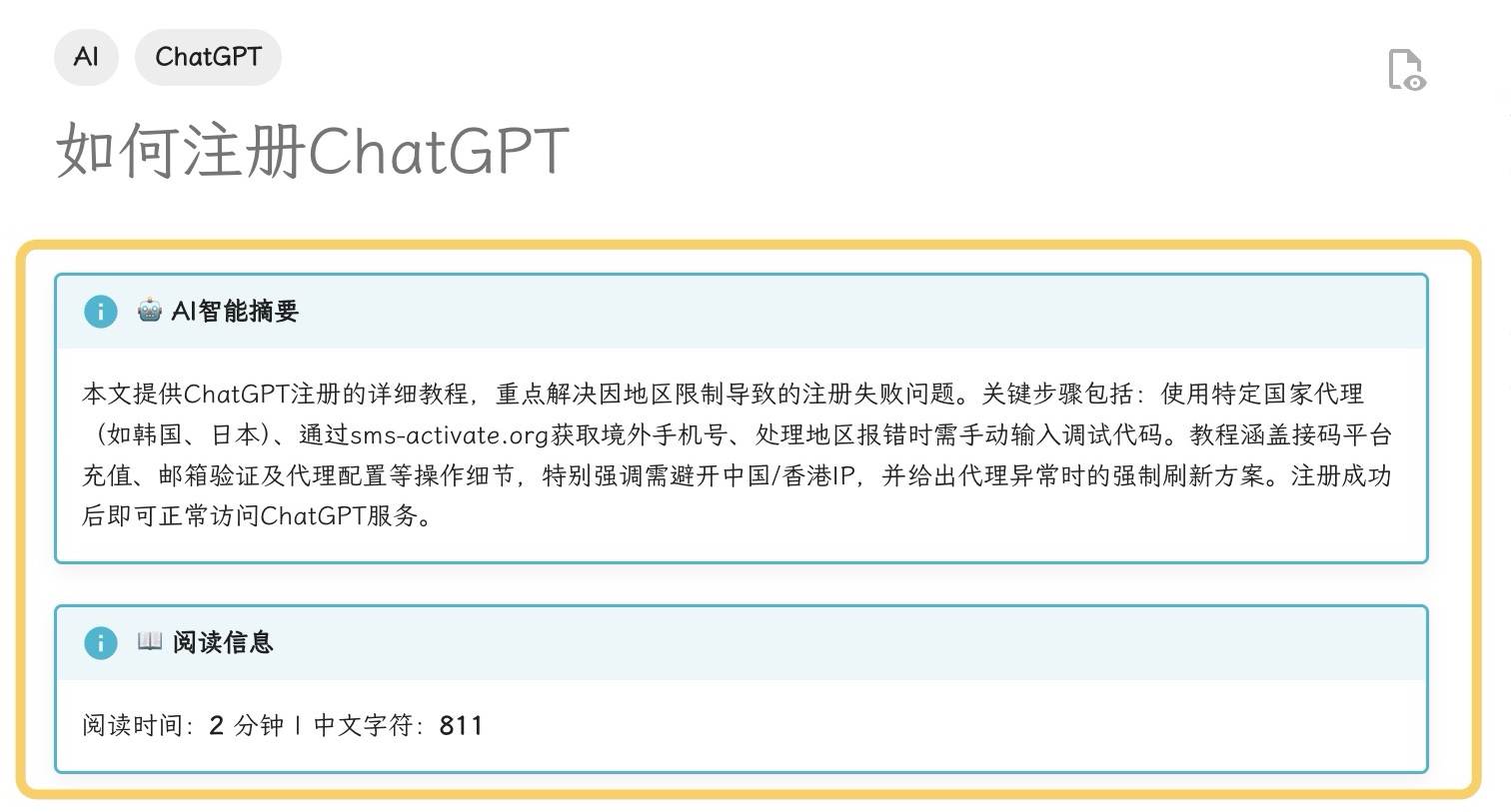

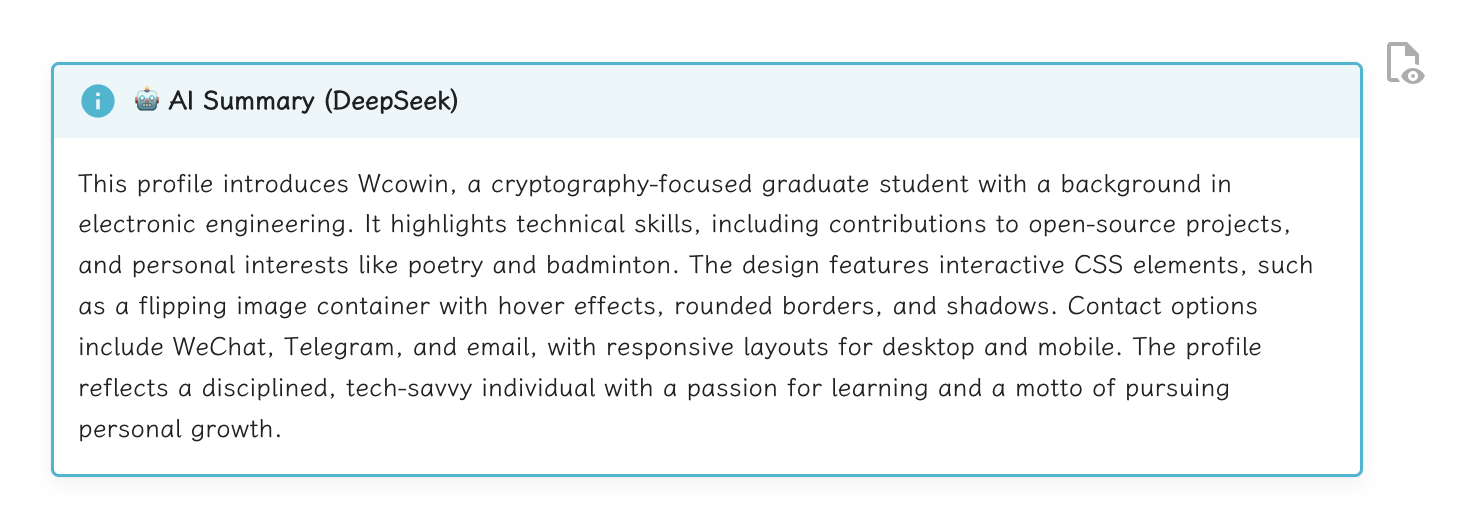

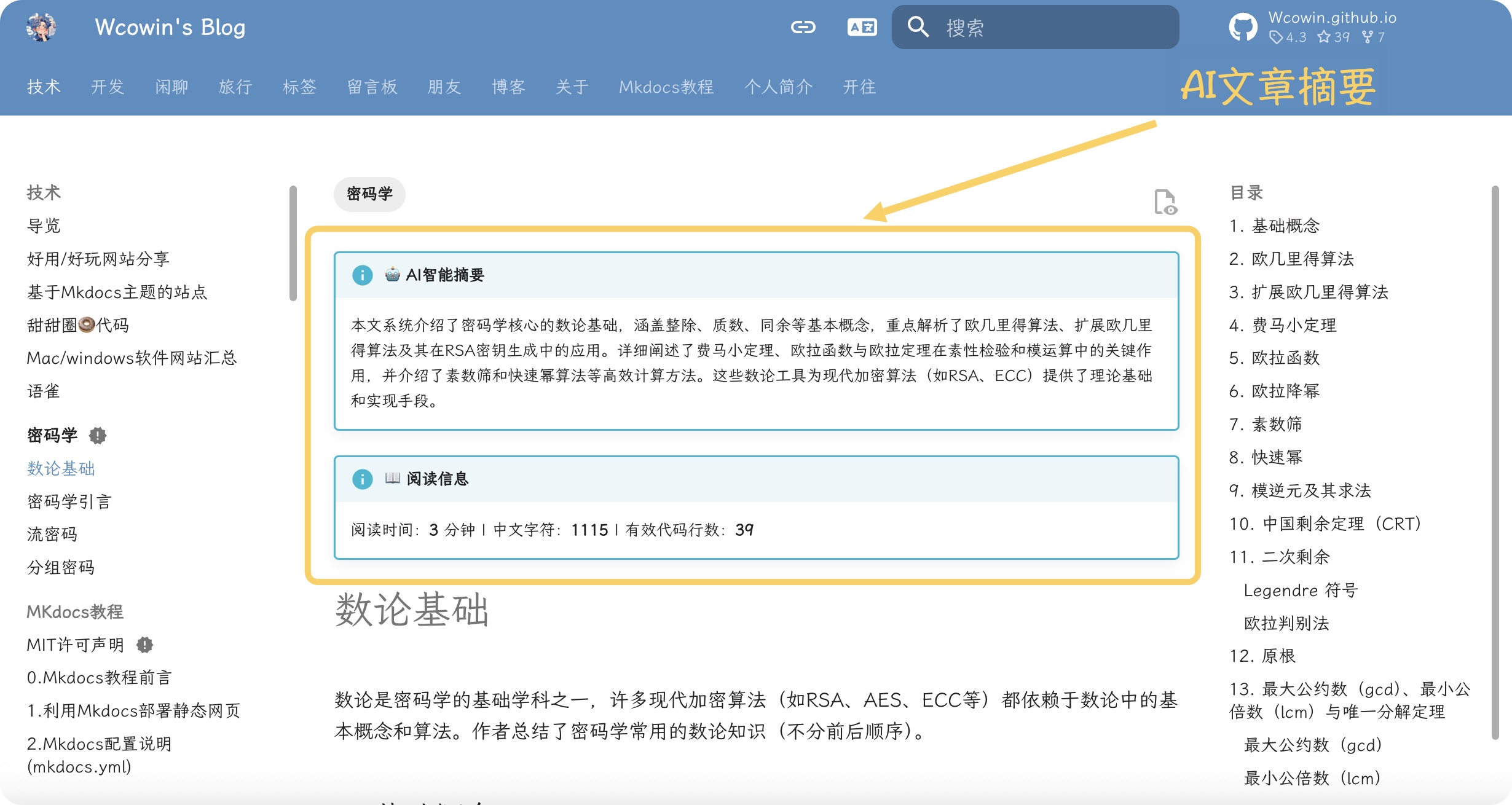

+ +🎨 显示效果¶

+AI摘要显示¶

+阅读信息显示¶

+实际效果:

+

API花费¶

+一次大约0.03-0.05元(中大型文档) +可以说相当经济实惠了!

+免费openai额度获取¶

+推荐使用:chatanywhere

+申请好后得到sk-开头的密钥,在ai_summary.py的多AI服务配置部分替换为以下内容:

+但是我这里也推荐使用DeepSeek API,额度充足且性能优秀。

+⚙️ 高级配置¶

+自定义API服务¶

+自定义提示词¶

+缓存配置¶

++切换api服务后,要删除site/.ai_cache这个缓存文件,才可以重新生成摘要!!!(这个问题已经解决了,切换api服务后,会自动删除缓存文件,无需手动删除) + +

+ +

+

Star History¶

+ +请作者喝杯咖啡¶

+

+

+  +

+

+ 如果这个项目对您有帮助,请给它一个 ⭐ Star! +

+ + + + +📝 本项目致力于让MkDocs文档更加智能化和用户友好。如有建议或想法,欢迎交流! + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + + +

+  +

+